Erweiterungen der Realität

Extended Realities in auditiven Kontexten

Ein Beitrag von Christina Zenk

Unsere physische Welt mit digitalen Informationen – Bilder, Videos, Texte – in Echtzeit zu kombinieren, ist nicht brandneu. Im Sommer 2016 jagten in einem regelrechten Hype um Pokémon Go unzählige Spieler mit ihren Smartphones über Straßen und Plätze um virtuelle Fantasiewesen zu fangen. Deutlich länger schon wird z.B. mit der virtuellen Abseitslinie in Fußball-Liveübertragungen auf Tools der sogenannten Augmented Reality zurückgegriffen. Und Navigations-Apps, die die Routenanweisungen direkt auf das Kamerabild von der realen Umgebung projizieren, sind auch keine Zukunftsmusik mehr.

Aktuell nimmt die Erweiterung von Realität jedoch eine rasante technische Entwicklung, die sich vor allem in einer größeren Nähe der Geräte am eigenen Körper und einer noch stärkeren Interaktion von Realem und Virtuellem im Alltag äußert. Bei der Präsentation der Microsoft Mixed-Reality-Brille HoloLens 2 auf dem Mobile World Congress in Barcelona am 24.2.2019 spielte die Entwicklerin Julia Schwarz live ein virtuelles Klavier. Das neue Trackingverfahren ermöglicht dabei das Spielen einzelner Töne sowie das Greifen von Akkorden. Die Entwicklungen gehen rasant voran: die aktuelle Microsoft-Brille ist nicht nur tragbarer, ein größeres Sichtfeld und die verbesserte Interaktion über Sprachsteuerung, Audiofeedback, Eye- und Motiontracking tragen zur Immersion bei: die Benutzer*innen tauchen in die erweiterte Realität ein, physische und virtuelle Welt verschwimmen zunehmend zu einer gemeinsamen Wahrnehmungs- und Handlungsebene.

Vielfalt an Begriffen

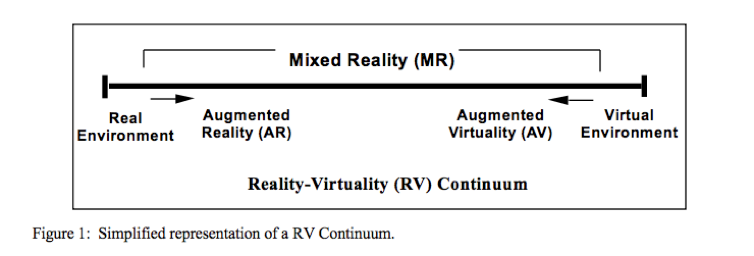

Im Zusammenhang mit der Erweiterung von Realität (Extended Reality) fallen viele Begriffe, wie Virtual Reality (VR), Augmented Reality (AR) und Mixed Reality (MR). Ein häufig zitierter Ansatz zur Sortierung dieser Begriffe existiert seit den 1990er Jahren (Milgram et al. 1994). Ausgehend von einem Kontinuum mit den Polen reale und virtuelle Umgebung, sind die erweiterten Realitäten dazwischen platziert. Auf der rechten Seite des Kontinuums ist die virtuelle Welt (VR), in der eine Umgebung gänzlich simuliert ist. Sie kann, muss aber nicht der realen Welt mit ihren Gesetzmäßigkeiten entsprechen. Von der Augmented Virtuality (AV) wird gesprochen, wenn eine simulierte Welt über Controller mit realen Sinneswahrnehmungen erweitert wird, indem man bspw. nach etwas greifen kann. Demgegenüber sieht man in der Augmented Reality (AR) die reale Welt, die durch virtuelle Objekte erweitert wird. Die Betrachtung des (realen) Eiffelturms wird so z.B. um die gleichzeitige Anzeige von Erläuterungen und Informationen über den Auftraggeber Gustave Eiffel ergänzt. Auf dem Kontinuum von der realen bis zur virtuellen Umgebung lassen sich also verschiedene Fälle platzieren, die zudem nach Einsatz der Technologien - sehe ich die AR durch einen Bildschirm oder durch eine Brille - charakterisiert werden. Die verschiedenen Möglichkeiten des „Augmented“ fasste Milgram als Mixed Realities zusammen; da man auf diesem Kontinuum mit einem gedachten Fader zwischen den Realitäten hin- und herschwenken kann, wird auch von X- oder Cross-Reality gesprochen (vgl. Mann et al. 2018).

(Milgram et al. 1994, S. 283)

Neben diesen begegnet man weiteren Begriffen wie Extended oder auch Expanded Reality, der wie Mixed Reality als ein Dachbegriff fungiert und ebenso alle Zwischenstufen des Kontinuums umfasst. Zur Begriffsverwirrung tragen viele neue verkaufsfördernde Markennamen bei, zugleich ist mit den technischen Innovationen in diesem Bereich eine (wissenschaftliche) Taxonomie noch nicht abschließbar. In einem aktuellen Aufsatz nennt der kanadische Informatiker Steve Mann weitere Realitäten, die durch die Verschmelzung von Technik und menschlichen Sinnen entstehen: in der Mediated Reality wird nicht nur eine weitere Ebene über die Realität gelegt, sondern Reales wird modifiziert, in dem sich bspw. Helligkeit filtern lässt und eine Wahrnehmungs- und Verarbeitungshilfe für den menschlichen Sehsinn geschaffen wird. Eine weitere Variante ist die Multimediated Reality (All R) in der Informationen jenseits der menschlichen Sinne für diese synthetisiert und damit wahrnehmbar werden (z.B. Wellenausbreitungen von Tönen)(Mann et al. 2018).

Aktuelle und zukünftige Anwendungsszenarien

In der Science-Fiction-Kurzgeschichte Pygmalion’s Spectacles von Stanley G. Weinbaum (1935) entwickelt ein verrückt anmutender Professor eine Brillenkonstruktion, mit der ein Film nicht nur gesehen, sondern gehört, geschmeckt, gefühlt und mit den Charakteren interagiert wird. Das Sensorama von Morton Heilig, ein Apparat mit stereoskopischem Bildschirm, Stereo-Lautsprechern, Duft-Strahlern und haptischem Feedback über Vibration, war 1962 die Einlösung dieser Fiktion. Das Head Mounted Display (HMD) war dann der nächste Schritt in der Mobilisierung multisensorischer Erlebnisse; seit seiner Erstentwicklung 1965 durch Ivan Sutherland ist es technisch gereift und bietet heute hochauflösende Bilder, schnelles Hand- und Sprachtracking. Die Unterhaltungsindustrie – mit den Medien Film und insbesondere Games – ist auch heute noch sicherlich einer der finanzstärksten Anwendungsbereiche und damit zugleich auch treibender Motor für die stetige technische Weiterentwicklung.

Darüber hinaus gibt es viele weitere Anwendungsszenarien. So wurde bereits 1994 für medizinische Zwecke das System MISTVR entwickelt, das es Studierenden ermöglicht, ihre Operationsfähigkeiten zu trainieren (Stone in Jung /tom Dieck 281 ff.). Mittlerweile gibt es voll immersive, virtuelle Trainingswelten wie LAP Mentor VR, in denen medizinische Eingriffe geübt werden (Video-Link).

Zugleich werden in Operationssälen Verfahren der Image Guided Surgery (Bildgeführte Operationen) angewandt, bei der vor oder während der Operation mit auf den Körper des Patienten projizierten Bildern (bspw. Röntgenbilder) gearbeitet wird. Zur Weiterbildung von Pflegepersonal werden spezielle virtuelle Videos gedreht, bei denen die Pflegekraft in die Haut eines Demenzkranken schlüpft und selbst erfährt, wie schwierig es mit dem Verlauf der Krankheit wird, auf Sprache zu reagieren oder sich zu erinnern.

Schließlich wird in der Psychotherapie die virtuelle Umgebung erfolgreich eingesetzt, sei es zur verhaltenstherapeutischen Behandlung von Höhen- oder Flugangst in virtuellen Expositionen, zur Erhöhung des Selbstwertgefühls bei Depressiven oder für eine veränderte Körperwahrnehmung bei Magersüchtigen (vgl. Riva et al. 2018; Falconer et al. 2016).

Vielfältige Szenarien in anderen Anwendungsbereichen sind bereits möglich: vom virtuellen Produktdesign und virtuellem Marketing über Arbeitsanleitungen über die AR-Brille bis hin zu virtuellen Klassenfahrten. Nicht zu vergessen ist aber auch der militärische Sektor als Anwendungsbereich mit einem Milliardenmarkt (vgl. Bspw. Jung/van Dieck 2018). Welche weiteren Anwendungsszenarien in der Zukunft noch denkbar sind, lässt sich nur schwer vorhersagen.

Wie stark virtuelle Erweiterungen unser Leben verändern werden, mag umstritten sein. Dass sie es tun, steht jedoch gemeinhin außer Frage. Nicht zuletzt die enormen Investitionen in Forschung und Entwicklung im Bereich virtueller Realität durch Firmen wie Google, Microsoft, Apple aber auch zahlreiche Start-Ups sind ein Indiz für das große Entwicklungspotential und eine damit einhergehende Veränderungserwartung. Bis 2025, so Scoble & Israel (2017), werden immer mehr Menschen die Erweiterungen ihrer Realität ganz selbstverständlich nutzen; zu erwarten ist eine schleichende, an manchen Stellen kaum bemerkbare Verschmelzung der technologischen Hilfsmittel mit dem realen Alltag der Menschen.

Extended Reality in künstlerischen Kontexten

Eines der ersten Künstler-Kollektive, die sich mit den ästhetischen Möglichkeiten der erweiterten Realität beschäftigten, war das Manifest.AR, die 2010 eine beeindruckende Ausstellung “We AR in MoMA” organisierten und 2011 ein entsprechendes Manifest aufsetzten:

Augmented Reality (AR) creates Coexistent Spacial Realities, in which Anything is possible— Anywhere!

The AR Future is without boundaries between the Real and the Virtual. In the AR Future we become the Media. Freeing the Virtual from a Stagnant Screen we transform Data into physical, Real-Time Space.

(Auszug, vgl. Geroimenko 2018: viii ff.)

Diese frühen Arbeiten verwenden mobile Augmented Reality: Durch das mobile Gerät sieht man kahle graue Großstadtgebäude, die nun aber mit virtuellen Pflanzen begrünt werden. Auch biometrische Daten werden einbezogen: Fällt das eigene Interesse während eines Vortrags ab, so zeigt mir der Bildschirm einen virtuellen Cheerleader-Avatar, der mich animiert und aufheitert.

Ein deutsches Beispiel für die Augmentierung von Realität ist das Projekt Maptory (2014) von Bernd Lintermann. Mit der App Karlsruhe Maptory werden an verschiedenen Orten in der Stadt über inszenierte Geschichten oder musikalische Ereignisse Karlsruher Persönlichkeiten der Wissenschaft und Kunst vorgestellt. Dabei sieht der Betrachter im Kamerabild seines Smartphones oder Tablets eine virtuelle Handlung, die auf den realen Hintergrund abgestimmt ist. In einer beeindruckenden Sequenz mauert bspw. der virtuelle Avatar von Clara Immerwahr, der naturwissenschaftlichen Pionierin, Pazifistin und Ehefrau des Giftgasforschers Fritz Haber, das Fenster eines realen Gebäudes von innen aus zu, während sie ihrer Verzweiflung über den Einsatz von Giftgas als Massenvernichtungswaffe im ersten Weltkrieg Ausdruck verleiht.

Künstler*innen haben heute – unter der Voraussetzung der technischen Umsetzbarkeit – die Wahl, mit allen möglichen sensorischen und virtuellen Kombinationen zu arbeiten. Mithilfe von Geotagging können z. B. Klänge mit bestimmten Orten verknüpft werden. Hierzu wertet das Mobilgerät die GPS-Daten der jeweiligen Position aus und gibt, an einem Zielort angekommen, Audioinhalte frei. Diese Inhalte können Video, Fotos, musikalische Werke oder auch Erzählungen sein, die z.B. innerhalb einer Stadt etwas über die jeweiligen Orte erfahrbar machen.

Mit Extended Reality entstehen verschiedene und neue Formate, die an diversen “Orten” zum Einsatz kommen: in Performances, Gemälden, Galerien, als Skulpturen, Street Art… Diese Artefakte werfen neue ästhetische Fragen auf: Welche Art von Kommunikation entsteht, wenn es zur Verschmelzung von Realität und Virtualität kommt? Wie bestimmen die Entscheidungen des Codings diese Kommunikation und Interaktionsmöglichkeiten, da Blicke, Gesten oder Positionen digital repräsentiert werden? Welche ästhetischen Erfahrungen werden ermöglicht und wie sind diese charakterisiert (vgl. Lichty 2018)?

Diese Fragen sind immer vor dem Hintergrund der technologischen Entwicklung zu diskutieren; mit der Überwindung technischer Hürden (bspw. Tracking-Geschwindigkeit und -Stabilität, Software-Integration von digitalen Inhalten in die physische Realität) sind weitere spannende künstlerische Ergebnisse zu erwarten.

Extended Reality & Musik

Die akustische Dimension in erweiterten Realitäten spielt sowohl in Anwendungsszenarien als auch in künstlerischen Kontexten eine wesentliche Rolle. Immersion ist der Begriff der Stunde, um zu beschreiben, dass sich ein Benutzer auf die Realität des Spiels oder des Films einlässt, in ihr aufgeht, sich ein Gefühl des realen Handelns einstellt.

Das Audiodesign und die Entwicklung von Raumklangtechnologien – bis dato ein Bereich, der vor allem von Avantgarde-Komponisten oder High-Fidelity-Audiospezialisten für Musik und Film bestellt wurde – erhielten damit einen innovativen Schub (vgl. Google Resonance Audio und Oculus Native Spatializer). Die Nachahmung von natürlichen Soundumgebungen mit Raumklang (Spatial Sounds), die über Echtzeit-Hall, binaurale Klänge oder Wellenausbreitungskontrolle hergestellt und in die VR-/AR-Umgebung gemixt werden, aber auch die Einbindung von Musik oder die Herstellung virtueller Instrumente orientieren sich bei ihrem Design immer mehr am Grad der Immersion des Nutzers.

Mit Blick auf die vielfältigen Erweiterungen und Neukonzeptionen musikalischer Instrumente der letzten Jahrzehnte müssen Instrumenten-Klassifikationen neu geschrieben werden (vgl. Bense 2013). Während traditionelle Kategorisierungen (von Sachs und von Hornbostel) materielle Eigenschaften oder Mechanismen der Klangproduktion fokussieren, steht man heute vor der Frage: Welcher Teil von bspw. interaktiven Synthesizern ist nun das Instrument? Die haptische Oberfläche oder die codierten Einheiten der Bedienungselemente, der Computer und/oder die Software? Mit der Digitalisierung von Klang und damit der Loslösung von einer bestimmten Spieltechnik vollziehen sich neue Möglichkeiten über Faktoren wie die Virtualisierung der Instrumente (vgl. Enders 2013).

Mit Virtual Musical Instruments – physische Interfaces die Klang über Eyetracking oder Motion Control beeinflussen oder digitale Interfaces und algorithmische Klangsynthese – wurde bereits reichlich experimentiert (vgl. Serafin et al. 2016). Ein aktuelles Beispiel sind die Mi.Mu Gloves, Handschuhe, mit denen Musiker*innen die von ihnen bestimmten musikalischen Parameter ihrer Musik über Hand- und Fingerbewegungen verändern können. Der deutsche Pianist Ralf Schmid nutzt die Handschuhe in seinem Programm PYANOOK, in dem er einerseits nach wie vor virtuos spielt, andererseits immer wieder die Hände hebt, dreht, um die vom Flügel abgenommenen Klänge mit Hallfahnen oder Filtern zu färben. Bei seinen Konzerten bindet er zusätzlich visuelles Material ein; über das System AR in Action (ARiA) werden Klänge und Rhythmen mit in Echtzeit kontrollierten, animierten Visualisierungen versehen.

Demgegenüber sind Virtual Reality Musical Instruments eine bislang unterrepräsentierte Kategorie. Sie zeichnen sich dadurch aus, dass visuelle Komponenten des Instruments virtuell simuliert werden. Sie lassen sich über ein Head-Mounted Display (HMD) oder eine Cave Automatic Virtual Environment (CAVE) erleben (vgl. Serafin et al. 2016). Neben der Erkundung und Verbesserung des Designs von Instrumenten (Reaktionszeit) ist es gerade nicht der reine Nachbau bereits existierender Instrumente, der viele ästhetische Fragen aufwirft, sondern die Konzeption neuartiger Möglichkeiten. Jenseits der Verbindung von Instrument, Finger, Raum lassen sich völlig andere Zusammenhänge, auch außerhalb der realen physikalischen Gesetze denken (vgl. Hamilton 2009). In diesem Sinne wird hier schon potentiell wahr, was Bernd Enders als die letzte Entwicklungsstufe von Instrumenten bezeichnet, die sich teils noch im experimentellen Stadium befinden mag: in der Hybridisierung von Instrumenten findet eine Art Verschmelzung zwischen Musikinstrument und Mensch statt, eine “performative Mensch-Maschine-Symbiose[n]” (Enders 2013: 64).

Extended Realities im Landeszentrum MUSIK–DESIGN–PERFORMANCE

Der Einsatz von Techniken und Anwendungen zur Erweiterung der Realität in musikalischen Kontexten stellt für Forschung, Lehre und künstlerische Praxis gleichermaßen ein spannendes und zukunftsweisendes Experimentierfeld dar. Das Landeszentrum MUSIK–DESIGN–PERFORMANCE setzte sich deshalb 2018 den thematischen Schwerpunkt Extended Reality. Im Sommersemester 2019 knüpft das Landeszentrum bei den Ateliertagen daran an. Vom 27. bis 29. Mai 2019 werden erweiterte Realitäten aus künstlerischer, wissenschaftlicher und pädagogischer Perspektive beleuchtet und diskutiert werden.

Das interdisziplinäre Symposium am Dienstag, 28. Mai 2019 thematisiert Die Rolle des Auditiven in immersiven erweiterten Realitäten von Monteverdi bis Virtual Reality. Aus den drei Perspektiven Medientheorie (Universität Konstanz), angewandte Medienwissenschaft (Hochschule Furtwangen University) und Musik (Musikhochschule Trossingen) werden aktuelle Entwicklungen und gemeinsame Forschungsperspektiven diskutiert und Räume des Transfers zwischen akademischem Diskurs, technischer Umsetzung, wirtschaftlicher Innovation und künstlerischer Praxis sondiert. Parallel wird auf der Messe Extended Instruments die Vielfalt der Möglichkeiten der technischen und digitalen Erweiterung „klassischer“ Instrumente vorgestellt. Von der präparierten Blockflöte über die virtuelle Orgel bis hin zur Raumklang-Performance im Klangdom reichen die Ausstellungsobjekte, die an der Musikhochschule genutzt und entwickelt werden. Im Klangdom wird dann auch das den Dienstag beschließende Atelier-Konzert sowie eine Open-Space-Night für Studierende stattfinden. Die Wahrnehmung von Musik wird in dieser Umgebung von kuppelförmig aufgehängten Lautsprechern entscheidend verändert. Klänge lassen sich an beliebigen Orten rund um den Hörer herum platzieren. Dieser nimmt den Klang nicht mehr frontal wahr, sondern befindet sich inmitten einer beliebigen Anzahl von Klängen.

Bereits am Montag, 27. Mai 2019 wird in verschiedenen Workshop-Formaten die Rolle von erweiterten Realitäten in der Musikpädagogik thematisiert. Mit der zunehmenden Digitalisierung verändern sich auch in musikpädagogischen Kontexten die Formen und Formate des Musizierens, Komponierens, Reflektierens und Konsumierens. Um zu einer Vorstellung der Möglichkeiten digitaler Dinge für den Musikunterricht zu kommen, bedarf es jedoch der Kenntnis über die Funktionen des Gerätes sowie der einzelnen Applikationen. In der Planung und Durchführung des Musikunterrichts mit digitalen Dingen, wie Tablets oder Smartphones (auch in den Händen der Lernenden) ist die Lehrkraft deshalb anders gefordert, Entscheidungen darüber zu treffen, wer welche mobilen digitalen Dinge wozu verwendet.

Zum Abschluss der Ateliertage wird es am Mittwoch, 29. Mai 2019 eine hochschulinterne Think-Tank-Runde geben. Das Landeszentrum MUSIK–DESIGN–PERFORMANCE lädt die Fachgruppensprecher und Institutsleiter der Hochschule dazu ein, gemeinsam Visionen der Zusammenarbeit zu entwickeln und Ideen für fachübergreifende Projekte zu konkretisieren.

Quellen

- Bense, Arne Till (2013): Musik und Virtualität. Digitale Virtualität im Kontext computerbasierter Musikproduktion. Osnabrück: epOs-Music.

- Enders, Bernd (2013): Vom Idiophon zum Touchpad. Die musiktechnologische Entwicklung zum virtuellen Instrument. In: Beate Flath (Hg.): Musik, Medien, Kunst. Wissenschaftliche und künstlerische Perspektiven. Bielefeld, S. 55-74.

- Falconer, Caroline J.; Rovira, Aitor; King, John A.; Gilbert, Paul; Antley, Angus; Fearon, Pasco; Ralph, Neil; Slater, Mel; Brewin; Chris R. (2016): Embodying self-compassion within virtual reality and its effects on patients with depression. In: BJPsych Open (2016) 2, S. 74-80. doi: 10.1192/bjpo.bp.115.002147.

- Geroimenko, Vladimir (Hg.)(2018): Augmented Reality Art From an Emerging Technology to a Novel Creative Medium. 2. Auflage. Springer.

- Hamilton, Robert K. (2009): Building Interactive Networked Musical Environments Using q3osc. In: Proceedings of the AES 35th International Conference: Audio for Games. S. 1-6.

- Jung, Timothy; tom Dieck, M. Claudia (Hgs.)(2018): Augmented Reality and Virtual Reality. Empowering Human, Place and Business. Springer.

- Lichty, Patrick (2018): The Aesthetics of Liminality: Augmentation as an Art Form. In: Geroimenko, Vladimir (Hg.): Augmented Reality Art. From an Emerging Technology to a Novel Creative Medium. Springer, S. 133-162.

- Mann, Steve; Furness, Tom; Yuan, Yu; Iorio, Jay; Whang, Zixin (2018): All Reality: Virtual, Augmented, Mixed (X), Mediated (X,Y), and Multimediated Reality. Online unter: https://arxiv.org/abs/1804.08386 (Submitted on 20 Apr 2018)(Zuletzt aufgerufen am 01.03.2019).

- Milgram, Paul; Takemura, Haruo; Utsumi, Akira; Kishino, Fumio (1994): Augmented Reality: A class of displays on the reality-virtuality continuum. In: SPIE Vol. 2351, Telemanipulator and Telepresence Technologies, S. 282-292. Online unter: http://etclab.mie.utoronto.ca/publication/1994/Milgram_Takemura_SPIE1994.pdf; Zuletzt aufgerufen am 01.03.2019.

- Riva, Giuseppe; Gaudio, Santino; Serino, Silvia; Dakanalis, Antonios; Ferrer-García, Marta; Gutiérrez-Maldonado, José (2018): Virtual Reality for the Treatment of Body Image Disturbances in Eating and Weight Disorders: A Guide to Assessment, Treatment, and Prevention. In: Cuzzolaro, Massimo & Fassino, Secondo (Hgs.): Body Image, Eating, and Weight. A Guide to Assessment, Treatment, and Prevention. Springer, S. 333-351.

- Scoble, Robert; Israel, Shel (2017): The Fourth Transformation: How Augmented Reality & Artificial Intelligence Will Change Everything. Patrick Brewster Press.

- Serafin, Stefania; Erkut, Cumhur; Kojs, Juraj; Nilsson, Niels C.; Nordahl; Rolf (2016): Virtual Reality Musical Instruments: State of the Art, Design Principles, and Future Directions. In: Computer Music Journal (2016) 40(3), S. 22-40.

- Stone, Robert J. (2018): Blending the Best of the Real with the Best of the Virtual: Mixed Reality Case Studies in Healthcare and Defence. In: Jung, Timothy; tom Dieck, M. Claudia (Eds.) (2018): Augmented Reality and Virtual Reality. Empowering Human, Place and Business. Springer. S. 277-293.